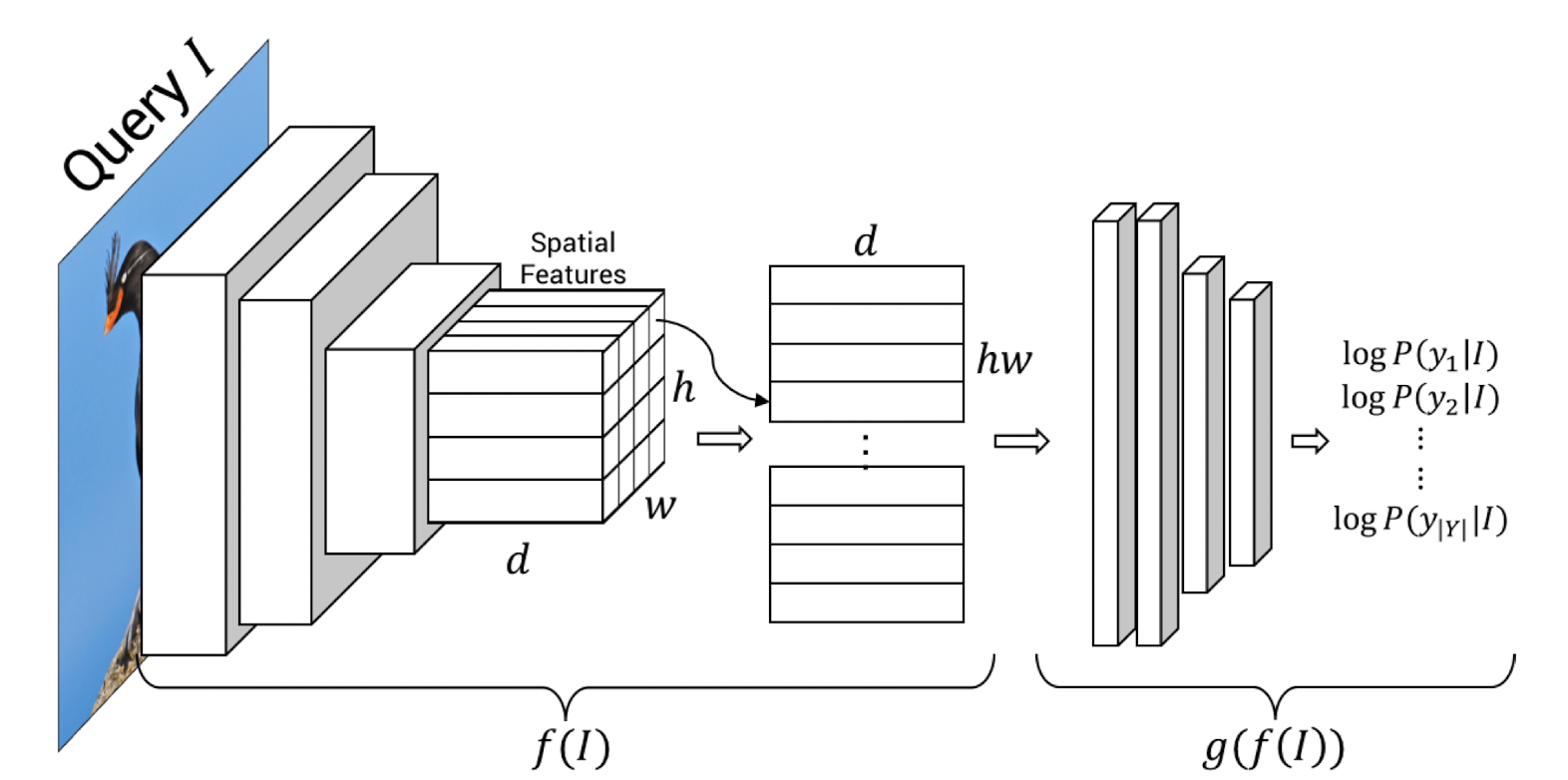

이전 연구 이전의 딥러닝 연구는 대안적인 결정을 고려하지 않고, input이 어떻게 하면 다른 output이 될지에 대해 가설상의 조정을 하지 않음 Contribution 1. input이 어떻게 바뀌면 다른 output이 나올지에 대해 어떤 영역을 정의해야하는지 computer vision system의 결정을 설명하려고 함 2. counterfactual explanation이 인간을 가르치는 것을 도와줄 수 있다는 것을 유저스터디를 통해 보여줌 저자들은 Counterfactual Visual Explanations를 위한 방법으로 다음과 같은 접근을 제안한다. 2.1. Minimum-Edit Counterfactual Problem Decomposition input Image : I, output..